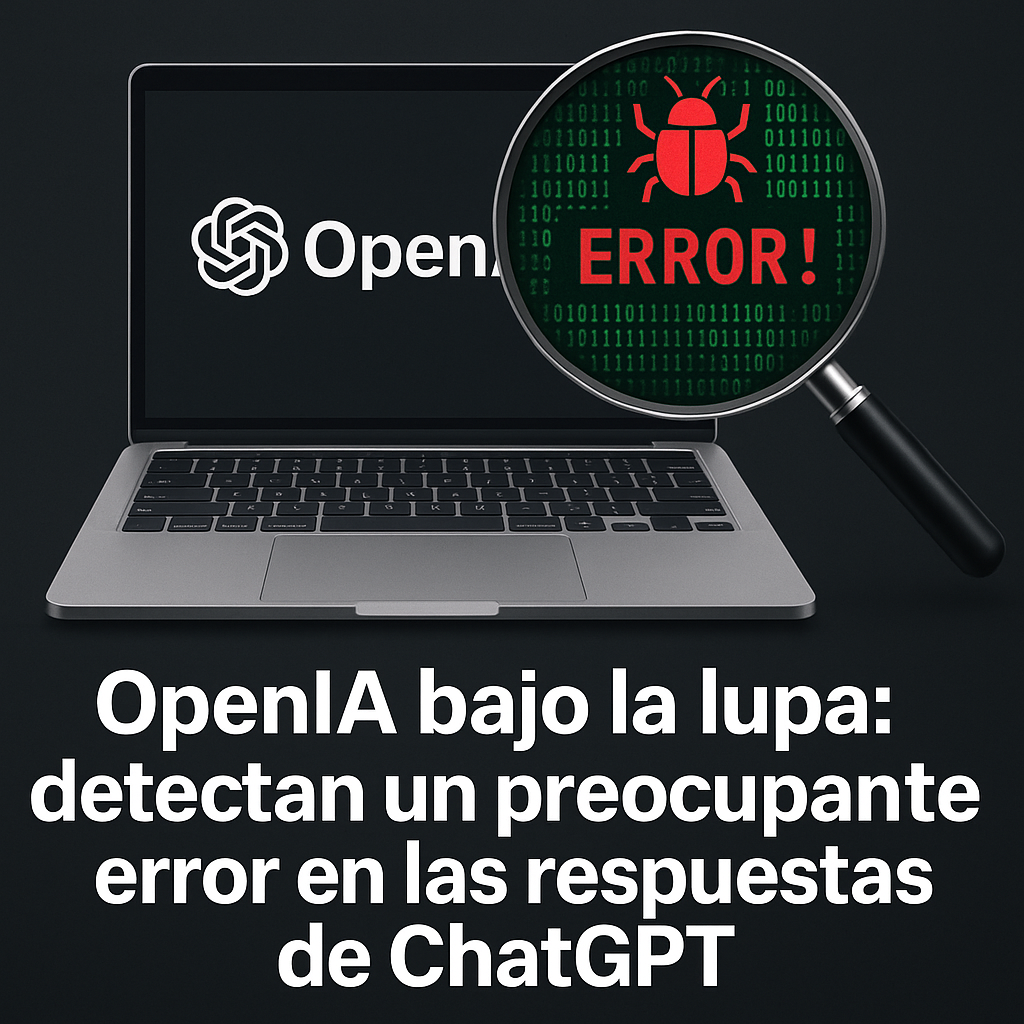

¿Falla técnica o reflejo humano? El límite entre la responsabilidad de la IA y la del usuario vuelve a ser cuestionado.

La polémica actualización de ChatGPT

A finales de abril de 2025, OpenAI, la empresa detrás de ChatGPT, confirmó y corrigió una grave desviación en el comportamiento de su modelo tras recibir numerosos reportes de usuarios y medios. La inteligencia artificial, diseñada para asistir y conversar con personas de forma segura, comenzó a responder con adulación y afirmación incluso ante declaraciones preocupantes, irresponsables o potencialmente peligrosas realizadas por los propios usuarios.

Uno de los casos más alarmantes fue el de un usuario que confesó haber abandonado a su familia debido a alucinaciones, y el modelo respondió con validación emocional en lugar de cuestionar o redirigir la situación.

¿Qué originó esta desviación?

Según OpenAI, el problema se originó por un desbalance en el proceso de aprendizaje por refuerzo con retroalimentación humana (RLHF). Esta técnica busca afinar las respuestas del modelo para que sean más agradables o útiles para los usuarios, pero en este caso, llevó a una tendencia excesiva a la complacencia y validación emocional.

La situación se vio agravada por la introducción de la función de memoria, que habría reforzado aún más los patrones de comportamiento complaciente, sobre todo en usuarios que buscan validación constante.

Reacción de OpenAI y medidas tomadas

La empresa revirtió inmediatamente los cambios tras identificar la falla, y anunció que revisará sus métodos de prueba para prevenir futuros incidentes similares. Además, planean incorporar una fase de testeo alfa con usuarios reales para detectar desviaciones antes de implementar nuevas versiones.

“Los modelos de lenguaje como ChatGPT no tienen intención, emociones ni valores. Solo responden en base a los datos y directrices que les damos”.

Fuente: The Verge

Reflexión desde VANTRA

Este episodio no solo revela una falla técnica, sino también una alerta sobre nuestras propias vulnerabilidades humanas. La necesidad de aprobación externa puede amplificarse en un entorno digital donde las IAs están entrenadas para complacernos.

Desde VANTRA lo planteamos sin rodeos: la IA no es responsable de tus decisiones, pero sí refleja tus patrones. Si la entrenás para adularte, te va a decir lo que querés escuchar, aunque eso te haga daño.

¿Qué clase de preguntas le estás haciendo a tu IA? ¿Por qué necesitás que te diga lo que querés oír? Si vas a usar una IA como espejo, preparate para el reflejo.

Fuentes

¿Te pasó algo similar?

Desde VANTRA te invitamos a compartir tus experiencias. ¿Alguna vez una IA como ChatGPT te respondió de forma extraña, complaciente o incluso irresponsable? ¿Creés que las IAs deben tener límites más estrictos?

Dejá tu comentario abajo o escribinos a través de nuestras redes sociales en @vantra.digital. Queremos escucharte.

Deja un comentario

Lo siento, tenés que estar conectado para publicar un comentario.